Immer mehr Unternehmen setzen künstliche Intelligenz (KI) in ihren Produkten und Internetseiten ein. Wir erklären, was Unternehmen nach der neuen KI-Verordnung beachten müssen, wenn sie KI entwickeln, nutzen oder verkaufen wollen.

Rechtsanwalt Niklas Plutte

Fachanwalt für gewerblichen Rechtsschutz

Rechtsanwältin Katja Schott

Unsere Kanzlei ist spezialisiert und IT-Recht, Urheberrecht und Persönlichkeitsrecht. Wir beraten Unternehmen bei Rechtsfragen rund um die Nutzung von künstlicher Intelligenz. Nutzen Sie unsere kostenlose Erstberatung.

Inhaltsübersicht

1. Was ist die KI-Verordnung?

2. Was regelt die KI-Verordnung?

3. Ab wann gilt die KI-Verordnung?

4. Wo gilt die KI-Verordnung?

5. Was sind KI-Systeme und KI-Modelle?

6. Was sind KI-Systeme oder KI-Modelle mit allgemeinem Verwendungszweck?

7. CHECK: Für wen gilt die KI-Verordnung?

8. Wann gilt die KI-Verordnung nicht?

9. Wie funktioniert das Risikosystem der KI-Verordnung?

a. Verbotene Praktiken

b. Hochrisiko-KI-Systeme

c. KI-Systeme mit begrenztem Risiko

d. KI-Systeme mit keinem oder geringem Risiko

e. KI-Systeme mit allgemeinem Verwendungszweck (GPAI)

10. Welche Anforderungen gelten für Hochrisiko-KI-Systeme?

11. Welche Pflichten gelten für Anbieter, Betreiber und andere Beteiligte?

a. Pflichten der Anbieter von Hochrisiko-KI-Systemen

b. Pflichten der Betreiber von Hochrisiko-KI-Systemen

c. Pflichten der Händler bei Hochrisiko-KI-Systemen

d. Allgemeine Pflichten für Anbieter und Betreiber aller Risikostufen

e. Pflichten der Anbieter von KI-Modellen mit allgemeinem Verwendungszweck

f. Pflichten der Anbieter von KI-Modellen mit allgemeinem Verwendungszweck und systemischem Risiko

g. Konkretisierung durch die EU

12. Welche Sanktionen drohen bei Verstoß gegen die KI-Verordnung?

13. Was ist hinsichtlich des Datenschutzrechts zu beachten?

Tipp: Beachten Sie auch unsere großen Rechts-FAQ zu ChatGPT und Co.

1. Was ist die KI-Verordnung?

Die EU-Verordnung 2024/1689 („KI-Verordnung“, „KI-VO“ oder „AI-Act“ genannt), ist das weltweit erste Gesetz, das sich umfassend der Regulierung von Künstlichen Intelligenz-Systemen und Künstlichen Intelligenz-Modellen widmet. Sie gilt unmittelbar in allen EU-Mitgliedsstaaten, ein zusätzliches deutsches Umsetzungsgesetz ist nicht erforderlich.

2. Was regelt die KI-Verordnung?

Die KI-VO soll einen einheitlichen Rechtsrahmen mit Regeln und Pflichten für die Verwendung und Entwicklung von künstlicher Intelligenz (KI) innerhalb des europäischen Binnenmarktes schaffen und die Grundrechte der Unionsbürger in Bezug auf die Auswirkungen von künstlicher Intelligenz schützen (Art. 1 Abs. 1 KI-VO).

Der EU-Gesetzgeber hat sich für einen Regulierungsansatz entschieden, bei dem die Anforderungen in der Verordnung nur umrissen und anschließend durch die europäischen Normungsorganisationen und die Anbieter selbst konkretisiert werden. Der Normungsprozess ist derzeit noch nicht abgeschlossen. Daher ist der Inhalt vieler Pflichten noch nicht final geklärt. Sobald der Normierungsprozess abgeschlossen ist, gilt eine sog. Konformitätsvermutung (Art. 40 Abs. 1 KI-VO): Durch Einhalten der Norm wird vermutet, dass der Akteur die entsprechende Pflicht der KI-VO erfüllt.

Privatorganisationen formen gesetzlichen Pflichtenrahmen: Die Entscheidung, die Konkretisierung von Pflichten nach der KI-VO auf Normierungsorganisationen zu übertragen, ist nicht unumstritten. Auf der einen Seite verfügen die Normierungsbehörden über einen hohen Sachverstand. Auf der anderen Seite handelt es sich um private Organisationen. Füllen diese den Inhalt eines Gesetzes aus, stellt sich die Frage, ob sie dazu überhaupt demokratisch legitimiert sind, da die europäischen Gesetzgebungsorgane auf den Normierungsprozess keine Einwirkung haben (vgl. Ebers/Streitbörger: Die Regulierung von Hochrisiko-KI-Systemen in der KI-VO (RDi 2024, 393)).

3. Ab wann gilt die KI-Verordnung?

Die KI-VO ist am 01.08.2024 in Kraft getreten und wird schrittweise wie folgt umgesetzt (Art. 113 KI-VO):

- Stufe 1: 02.02.2025

Die allgemeinen Regelungen der KI-Verordnung sind zu beachten. Das Verbot des Einsatzes von KI-Systemen mit inakzeptablen Praktiken greift, Art. 113 Satz 3 lit. a KI-VO. Anbieter und Betreiber müssen KI-Kompetenz aufbauen.

- Stufe 2: 02.08.2025

Die Verpflichtungen für KI-Modelle mit allgemeinen Verwendungszweck treten in Kraft. Diese umfassen Kapitel III Abschnitt 4, Kapitel V, Kapitel VII und Kapitel XII sowie Art. 78 KI-VO, Art. 113 Satz 3 lit. b KI-VO. Geldbußen für Anbieter von KI-Modellen mit allgemeinen Verwendungszweck sind zu diesem Zeitpunkt noch ausgenommen, Art. 101 der KI-VO.

- Stufe 3: 02.08.2027

In der letzten Stufe treten die restlichen Bestimmungen der KI-VO in Kraft, insbesondere die Pflichten für Hochrisiko-KI-Systemen aus Anhang III KI-VO, Art. 113 Satz 3 lit. c KI-VO.

4. Wo gilt die KI-Verordnung?

Die KI-Verordnung greift bei Bezug zur EU oder dem europäischen Binnenmarkt. Sie gilt also nicht nur innerhalb der EU-Mitgliedstaaten, sondern auch im gesamten Europäischen Wirtschaftsraum (EWR) sowie zusätzlich in Norwegen, Island und Liechtenstein. Entscheidend ist nicht nur der geografische Standort, sondern auch, wo ein KI-System angeboten, eingesetzt oder verwendet wird.

Für Anbieter von KI-Systemen greift das sogenannte Marktortprinzip. Das bedeutet: Die KI-Verordnung gilt unabhängig vom Sitz des Anbieters, sobald ein KI-System in der EU oder im EWR bereitgestellt, in Verkehr gebracht oder in Betrieb genommen wird. Dies betrifft auch Unternehmen mit Sitz außerhalb der EU, sofern deren KI-Systeme auf den europäischen Markt ausgerichtet sind.

Für Betreiber von KI-Systemen gilt hingegen das Niederlassungsprinzip. Maßgeblich ist hier, ob die betreffende Organisation oder Person ihren Sitz oder eine Niederlassung innerhalb der Union hat.

5. Was sind KI-Systeme und KI-Modelle?

Zunächst ist es wichtig zu verstehen, was KI-Systeme und KI-Modelle im Sinne der KI-VO sind.

Nach Art. 3 Nr. 1 KI-VO ist ein KI-System definiert als

„ein maschinengestütztes System, das für einen in unterschiedlichem Grade autonomen Betrieb ausgelegt ist und das nach seiner Betriebsaufnahme anpassungsfähig sein kann und das aus den erhaltenen Eingaben für explizite oder implizite Ziele ableitet, wie Ausgaben wie etwa Vorhersagen, Inhalte, Empfehlungen oder Entscheidungen erstellt werden, die physische oder virtuelle Umgebungen beeinflussen können“.

Demnach sind KI-Systeme Softwareanwendungen, die auf Basis von Daten arbeiten, diese analysieren und selbständige Ergebnisse wie Vorhersagen, Empfehlungen oder Entscheidungen generieren. Diese Ergebnisse können sowohl die reale als auch die virtuelle Umgebung beeinflussen.

Bekannte Beispiele für KI-Systeme, die nahezu jeder schon einmal genutzt hat, sind Sprachassistenten wie Siri, Alexa oder Google Assistant.

Der Begriff des KI-Modells wird in der KI-VO nicht definiert. Im Unterschied zum KI-System, das eine zur Nutzung geeignete Anwendung darstellt, versteht man unter einem KI-Modell das hinter dem KI-System stehende Element. Ein KI-Modell allein ist daher also noch kein KI-System. Damit ein KI-System entsteht, sind zusätzliche Komponenten erforderlich, wie z.B. eine Nutzerschnittstelle, die die Interaktion mit dem System ermöglicht (vgl. Wendt in Wendt/Wendt, Das neue KI-Recht, § 10 Rn. 8). Ein KI-System kann aus einem oder mehreren KI-Modellen bestehen. Die KI-Modelle werden mit Datensätzen trainiert, um Muster zu erkennen und entsprechenden Output zu erzeugen (What is AI).

6. Was sind KI-Systeme oder KI-Modelle mit allgemeinem Verwendungszweck?

Die KI-VO spricht häufig von KI-Systemen oder KI-Modellen mit allgemeinem Verwendungszweck. Der Begriff der KI-Systeme mit allgemeinem Verwendungszweck, auch als generative KI-Systeme bekannt, wurde in der KI-VO ursprünglich nicht berücksichtigt. Erst nachdem OpenAI im November 2022 ChatGPT der breiten Öffentlichkeit zugänglich gemacht hatte, wurde klar, dass auch KI-Systeme mit allgemeinem Verwendungszweck in der Verordnung zu berücksichtigen seien (vgl. Wendt in Wendt/Wendt, Das neue KI-Recht, § 10 Rn. 17-19).

- Ein KI-System mit allgemeinem Verwendungszweck ist nach Art. 3 Nr. 66 KI-VO ein KI-System, das auf einem KI-Modell mit allgemeinem Verwendungszweck beruht und in der Lage ist, einer Vielzahl von Zwecken sowohl für die direkte Verwendung als auch für die Integration in andere KI-Systeme zu dienen.

- Ein KI-Modell mit allgemeinem Verwendungszweck ist nach Art. 3 Nr. 63 KI-VO ein KI-Modell, dass eine erhebliche allgemeine Verwendbarkeit aufweist und in der Lage ist, unabhängig von der Art und Weise seines Inverkehrbringens ein breites Spektrum unterschiedlicher Aufgaben kompetent zu erfüllen, und das in eine Vielzahl nachgelagerter Systeme oder Anwendungen integriert werden kann.

Ein Beispiel für ein KI-Modell mit allgemeinem Verwendungszweck ist GPT-4, das ChatGPT zum Zeitpunkt der Veröffentlichung dieses Beitrags zugrunde liegende KI-Modell.

7. CHECK: Für wen gilt die KI-Verordnung?

Die KI-VO richtet sich vor allem an Anbieter (Provider) und Betreiber (Developer) von KI-Systemen und -Modellen. Ihre Geltung ist standortunabhängig. Nach Art. 2 Abs. 1 lit. c KI-VO erfasst sie auch Anbieter und Betreiber mit Sitz in Drittstaaten, sofern das KI-System innerhalb der EU genutzt wird oder der daraus resultierende Output in der EU Verwendung findet (vgl. Wendt in Wendt/Wendt, Das neue KI-Recht, § 3 Rn. 53).

Die KI-VO definiert Anbieter und Betreiber wie folgt:

Anbieter ist nach Art. 2 Abs.1 lit. a KI-VO in Verbindung mit Art. 3 Nr. 3 KI-VO eine natürliche oder juristische Person, Behörde, Einrichtung oder sonstige Stelle, die ein KI System oder ein KI Modell mit allgemeinem Verwendungszweck entwickelt oder entwickeln lässt und es unter eigenen Namen oder Handelsmarke in Verkehr bringt (Art. 3 Nr. 9 KI-VO) oder das KI System unter eigenen Namen oder Handelsmarke in Betrieb nimmt (Art. 3 Nr. 10 KI-VO), sei es entgeltlich oder unentgeltlich. Die Definition umfasst somit auch Akteure, die KI-Systeme fremdentwickeln lassen und sie auf den Markt bringen oder selbst in Betrieb nehmen. Ausgenommen sind dagegen Personen, die Modelle für nicht berufliche oder wissenschaftliche Forschungszwecke entwickeln oder verwenden (Erwgr. 109, Satz 1 KI-VO).

Betreiber ist nach Art. 2 Abs.1 lit. b KI-VO in Verbindung mit Art. 3 Nr. 4 KI-VO eine natürliche oder juristische Person, Behörde, Einrichtung oder sonstige Stelle, die ein KI System in eigener Verantwortung verwendet, es sei denn, das KI System wird im Rahmen einer persönlichen und nicht beruflichen Tätigkeit verwendet.

Betreiber sind beispielsweise Unternehmen, die ein handelsübliches KI-System in ihrem Betrieb einsetzen. Durch die stark zunehmende Integration von künstlicher Intelligenz in Unternehmensprozessen aller Ebenen ist diese Variante für viele Firmen relevant.

KI-Risikoprüfung

Gehören Sie zur Zielgruppe der KI-VO? Prüfen Sie anhand der folgenden Punkte, ob Sie von der Verordnung betroffen sind:

Art. 25 KI-VO regelt den Fall, dass ein Betreiber in die Rolle des Anbieters „einrückt“. Nimmt ein Betreiber wesentliche Veränderungen an einem bereits in den Verkehr gebrachten KI-System vor, wodurch das KI-System als Hochrisiko-KI zu qualifizieren ist, rückt der Betreiber in die Rolle des Anbieters ein. Das Gleiche gilt, wenn ein Betreiber ein KI-System, das vorher nicht als hochriskant eingestuft wurde, zu einem Zweck verwendet, der unter den Katalog der Hochrisiko-KI-Systeme fällt.

Beispiel: Setzt ein Unternehmen ChatGPT in einer Weise ein, dass die Anwendung von der KI-VO als Hochrisiko-Anwendung eingestuft wird (etwa in einem Bewerbungsprozess), muss das Unternehmen (das grundsätzlich nur „Betreiber“ ist), die Pflichten für „Anbieter“ von Hochrisiko-KI-Systemen beachten. Das ist nicht unproblematisch: Rückt man als Betreiber in die Anbieterpflichten ein, kann es notwendig werden, ein Konformitätsbewertungsverfahren durchzuführen. Dieses Verfahren kann bei einer Nutzung von ChatGPT ohne die Mitwirkung von OpenAI, dem Unternehmen hinter ChatGPT, nicht bewerkstelligt werden (vgl. Ebers/Streitbörger: Die Regulierung von Hochrisiko-KI-Systemen in der KI-VO (RDi 2024, 393)).

Zum Spannungsfeld der Kooperationspflicht des Art. 25 KI-VO und möglicher Geschäftsgeheimnisse empfehlen wir diesen vertiefenden Beitrag der geschätzten Kollegen von Löffel Abrar.

8. Wann gilt die KI-Verordnung nicht?

Die KI-VO gilt nicht für Verbraucher, die KI Systeme im Rahmen einer ausschließlich persönlichen und nicht beruflichen Tätigkeit verwenden (Art. 2 Abs. 10 KI-VO).

Auch die meisten Open-Source-KI-Systeme sind von der Anwendbarkeit der KI-VO ausgeschlossen. Eine Ausnahme besteht, wenn sie als Hochrisiko-KI-Systeme oder als KI-Systeme, die unter Art. 5 KI-VO oder Art. 50 KI-VO fallen, in Verkehr gebracht oder in Betrieb genommen werden (Art. 2 Abs. 12 KI-VO). Dazu zählen beispielsweise quelloffene Hochrisiko-KI-Systeme, die synthetische Inhalte wie Bilder, Texte, Audio- und Videodateien erzeugen (z.B. Deepfakes) oder für Emotionserkennung und biometrische Kategorisierung eingesetzt werden.

Weiter von der KI-VO ausgenommen sind:

- KI-Systeme, die mit oder ohne Änderung ausschließlich für militärische Zwecke, Verteidigungszwecke oder Zwecke der nationalen Sicherheit in Verkehr gebracht, in Betrieb genommen oder verwendet werden (Art. 2 Abs. 3 Abs. 2 KI-VO) und

- KI-Systeme und KI-Modelle, die allein für Forschungs- und Entwicklungszwecken dienen (Art. 2 Abs. 6 KI-VO).

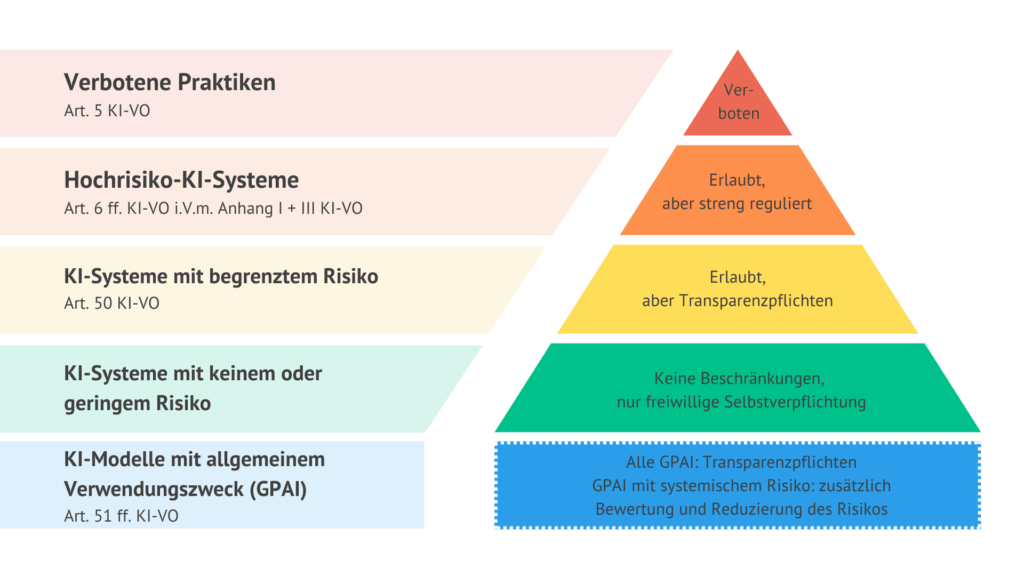

9. Wie funktioniert das Risikosystem der KI-Verordnung?

Die KI-VO unterteilt KI-Systeme in die vier Risikostufen. Je nach Risikostufe kann die KI völlig einschränkungslos nutzbar sein, Beschränkungen unterliegen oder verboten sein. Neben den vier Risikostufen, die sich an dem Gefahrenpotenzial der konkreten Anwendung eines KI-Systems orientieren gibt es noch die KI-Systeme mit allgemeinem Verwendungszweck (Art. 51 ff. KI-VO). Bei KI-Systemen mit allgemeinem Verwendungszweck lässt sich gerade kein konkretes Anwendungsszenario ausmachen (vgl. Wendt in Wendt/Wendt Das neue KI-Recht, § 3 Rn. 48), weswegen diese nicht vom Risiko-Stufensystem der KI-VO umfasst sind.

a. Verbotene Praktiken

KI-Systeme, die Praktiken einsetzen, die der Liste des Art. 5 KI-VO unterfallen, sind verboten. Hierzu zählen KI-Systeme, die

- Betroffene unterschwellig beeinflussen oder absichtlich manipulieren oder täuschen mit dem Ziel, die Betroffenen in ihrer Entscheidungsfindung zu beeinflussen und sie oder andere Personen zu einem schädigenden Verhalten zu bewegen,

- die Schutzbedürftigkeit und Vulnerabilität von bestimmten Personen ausnutzen (z.B. Alter, Behinderung oder die wirtschaftliche und soziale Situation), um ein schädigendes Verhalten hervorzurufen oder ein solches mit hoher Wahrscheinlichkeit hervorrufen,

- Social Scoring vornehmen, z.B. Bonitäts-Scoring bei der Vergabe von Krediten,

- Predictive Policing, also die Risikobewertung von natürlichen Personen zur Berechnung der Wahrscheinlichkeit zukünftiger Straftaten ohne vorausgehende menschliche Analyse, die auf objektiven und überprüfbaren Tatsachen beruht,

- Datenbanken zur Gesichtserkennung durch das ungezielte Auslesen von Gesichtsbildern aus dem Internet oder von Überwachungsaufnahmen erstellen oder erweitern,

- Emotionserkennung am Arbeitsplatz oder in Bildungseinrichtungen ermöglichen,

- Biometrische Fernidentifizierung von Personen, um Rückschlüsse über Merkmale wie ihre Rasse, politische Überzeugung oder sexuelle Orientierung zu ziehen.

b. Hochrisiko-KI-Systeme

Den Schwerpunkt der KI-VO bilden die Hochrisiko-KI-Systemen nach Art. 6 ff. KI-VO. Diese sind nicht verboten, aber streng reguliert. Der Gesetzgeber hat sich für ein dynamisches System zur Klassifizierung von Hochrisiko-KI-Systemen entschieden. Die Einstufung hängt von der Anwendung und den möglichen Auswirkungen auf Grundrechte, Gesundheit oder Sicherheit ab. Wann liegt ein Hochrisiko-KI-System vor? Nach Art. 6 Abs. 1 KI-VO fallen unter Hochrisiko-KI-Systeme solche, die als Sicherheitsbauteil für ein Produkt dienen, das bereits Regelungsgegenstand eines in Anhang I Abschnitt A der VO aufgeführtem EU-Rechtsakts ist oder das KI-System selbst ein solches Produkt ist.

Dazu zählen Maschinen, Spielzeuge, Medizinprodukte aber auch Aufzüge, Druckgeräte und Funkanlagen (vgl. Wendt in Wendt/Wendt, Das neue KI-Recht § 4 Rn. 23). Hochrisiko-KI-Systeme müssen, bevor diese in den Verkehr gebracht oder in Betrieb genommen werden, einer Konformitätsbewertung durch Dritte unterzogen werden. Diese Bewertung erfolgt gemäß den in Anhang I der KI-VO aufgeführten Harmonisierungsrechtsvorschriften der Union (Art. 6 Abs. 1 lit. b KI-VO). Zusätzlich zu den in Art. 6 Abs. 1 KI-VO genannten Hochrisiko-KI-Systemen gelten gemäß Art. 6 Abs. 2 KI-VO auch die in Anhang III als hochriskant. Diese KI-Systeme werden aufgrund ihres sensiblen Anwendungsbereichs eigenständig von der KI-VO als Hochrisiko-System eingestuft. Unter Anhang III der KI-VO fallen die folgenden Bereiche:

- Biometrie beispielsweise zur Fernidentifizierung oder zur Emotionserkennung (Anhang III Nr. 1 zur KI-VO),

- Kritischer Infrastruktur (Anhang III Nr. 2 zur KI-VO)

- Allgemeine und berufliche Bildung, beispielsweise KI-Systeme, die Zugangs- oder Zulassungsentscheidungen zu Bildungseinrichtungen vornehmen (Anhang III Nr. 3 zur KI-VO),

- Beschäftigung, Personalmanagement und Zugang zur Selbstständigkeit, z.B. KI-System die in Bewerbungsverfahren oder im Rahmen von Beförderungs- oder Kündigungsentscheidungen zum Einsatz kommen (Anhang III Nr. 4 zur KI-VO),

- Zugänglichkeit und Inanspruchnahme grundlegender privater und öffentlicher Diensten und Leistungen, z.B. indem sie die Kreditwürdigkeit oder Bonität von Betroffenen bewerten oder für die Risikobewertung oder Preisbildung von Lebens- und Krankenversicherungen eingesetzt werden (Anhang III Nr. 5 zur KI-VO),

- Strafverfolgung (Anhang III Nr. 6 zur KI-VO),

- Migration, Asyl und Grenzkontrollen (Anhang III Nr. 7 zur KI-VO) oder

- Rechtspflege und demokratischen Prozessen (Anhang III Nr. 8 zur KI-VO).

Ein KI-System gilt gemäß Art. 6 Abs. 3 Satz 1 KI-VO nicht als hochriskant, wenn es kein erhebliches Risiko der Beeinträchtigung in Bezug auf die Gesundheit, Sicherheit oder Grundrechte natürlicher Personen birgt, indem es u.a. nicht das Ergebnis der Entscheidungsfindung wesentlich beeinflusst. Ein Ergebnis wird beeinflusst, wenn mindestens eine der folgenden Bedingungen erfüllt ist:

Das KI-System ist dazu bestimmt

- eine eng gefasste Verfahrensaufgabe durchzuführen;

- das Ergebnis einer zuvor abgeschlossenen menschlichen Tätigkeit zu verbessern;

- Entscheidungsmuster oder Abweichungen von früheren Entscheidungsmustern zu erkennen, und ist nicht dazu gedacht, die zuvor abgeschlossene menschliche Bewertung, ohne eine angemessene menschliche Überprüfung zu ersetzen oder zu beeinflussen oder

- eine vorbereitende Aufgabe für eine Bewertung durchzuführen, die für die Zwecke der in Anhang III aufgeführten Anwendungsfälle relevant ist.

Ausnahme: Unabhängig von den oben genannten Bedingungen ist ein KI-System als hochriskant einzustufen, wenn es ein Profiling natürlicher Personen vornimmt, Art. 6 Abs. 3 Satz 3 KI-VO. Gemäß Art. 6 Abs. 5 KI-VO soll die EU-Kommission nach Konsultation des Europäischen Gremiums für Künstliche Intelligenz spätestens innerhalb von 18 Monaten nach Inkrafttreten der KI-VO Leitlinien sowie eine umfassende Liste von Regel- und Gegenbeispielen für eine rechtssichere Einstufung von KI-Systeme veröffentlichen. Dadurch sollen sowohl Unternehmen als auch Behörden unterstützt werden, ein korrekte Risikoeinstufung vorzunehmen.

c. KI-Systeme mit begrenztem Risiko

Ein begrenztes Risiko umfassen KI-Systeme mit Transparenzrisiko. Darunter fallen solche KI-Systeme, die direkt mit Menschen interagieren. Die Anbieter solcher KI-Systeme sollen gemäß Art. 50 Abs. 1 KI-VO sicherstellen, dass Personen, die mit einem KI-System interagieren, hierüber informiert sind. Die Information soll den Nutzern spätestens zum Zeitpunkt der ersten Interaktion oder Aussetzung in klarer und eindeutiger Weise bereitgestellt werden (Art. 50 Abs. 5 KI-VO). Dies ist ausnahmsweise dann nicht erforderlich, wenn aus Sicht einer angemessenen informierten, aufmerksamen und verständigen natürlichen Person aufgrund der Umstände und des Kontexts der Nutzung offensichtlich ist, dass es sich um eine Interaktion mit einem KI-System handelt (Art. 50 Abs. 1 KI-VO). Darunter fallen insbesondere (KI-)Chatbots sowie Deepfakes (Art. 3 Nr. 60 KI-VO).

d. KI-Systeme mit keinem oder geringem Risiko

KI-Systeme, die nicht unter die obigen drei Stufen fallen, sind in die vierte Kategorie einzuordnen. Für solche KI-Systeme gelten keine besonderen Regeln, da von ihnen nur ein minimales Risiko ausgeht. Für diese Systeme können Anbieter freiwillige Verhaltenskodizes entwickeln und diese einhalten.

Ein Beispiel für ein KI-System mit keinem oder minimalem Risiko sind Spamfilter.

e. KI-Systeme mit allgemeinem Verwendungszweck (GPAI)

Ein KI-Modell mit allgemeinem Verwendungszweck („General Purpose Artificial Intelligence“, kurz „GPAI“) weist ein systemisches Risiko auf, wenn es über Fähigkeiten mit hoher Wirkkraft bzw. hohem Wirkungsgrad verfügt. Dabei sind zwei Wege vorgesehen, worüber ein systemisches Risiko festgestellt werden kann (vgl. Bernsteiner/Schmitt in Martini/Wendehorst, KI-VO, Art. 51 Rn. 21):

- Feststellung eines systemischen Risikos mithilfe geeigneter technischer Instrumente und Methoden bewertet werden, wobei sich die Geeignetheit nach dem Stand der Technik einerseits und den Fähigkeiten bzw. Einsatzmöglichkeiten des KI-Modells anderseits richten wird (vgl. Martini/Wendehorst a.a.O.), Art. 51 Abs. 1a KI-VO).

- Die Feststellung durch Entscheidungen der Kommission von Amts wegen oder aufgrund von qualifizierten Warnung des wissenschaftlichen Gremiums unter Berücksichtigung der in Anhang XII der KI-VO festgelegten Kriterien (vgl. Martini/Wendehorst a.a.O.), (Art. 51 Abs. 1b KI-VO).

Ein systemisches Risiko wird in Art. 3 Nr. 65 KI-VO definiert als

„ein Risiko, das für die Fähigkeiten mit hoher Wirkkraft von KI Modellen mit allgemeinem Verwendungszweck spezifisch ist und aufgrund deren Reichweite oder aufgrund tatsächlicher oder vernünftigerweise vorhersehbarer negativer Folgen für die öffentliche Gesundheit, die Sicherheit, die öffentliche Sicherheit, die Grundrechte oder die Gesellschaft insgesamt erhebliche Auswirkungen auf den Unionsmarkt hat, die sich in großem Umfang über die gesamte Wertschöpfungskette hinweg verbreiten können“

Um diesem gesteigerten Risiko zu begegnen, gelten für KI-Systeme und Modelle mit systemischem Risiko verschärfte Regeln (siehe Ziffer 8e).

10. Welche Anforderungen gelten für Hochrisiko-KI-Systeme?

Hochrisiko-KI-Systeme müssen eine Vielzahl von Anforderungen erfüllen:

- Einrichten und Führen eines Risikomanagementsystems für KI-Systeme (Art. 9 KI-VO): Der Anbieter hat die zu erwartenden Risiken des KI-Systems zu identifizieren und Maßnahmen zu ergreifen, diese Risiken zu bewältigen. Unter dem Begriff „Risiko“ sind vorhersehbare Schäden unter Berücksichtigung ihrer Wahrscheinlichkeit und Schwere zu verstehen. Der Betrachtungshorizont erstreckt sich zunächst auf die Verwendung des KI-Systems entsprechend seiner Zweckbestimmung (vgl. Wendt in Wendt/Wendt, Das neue KI-Recht, § 5 Rn. 7). Mit dem Risikomanagementsystem soll kontinuierlich während des gesamten Lebenszyklus der KI überprüft werden, welche Risiken von dem KI-System ausgehen und wie diese Risiken bewältigt werden können.

- Daten-Governance (Art. 10 KI-VO): Anbieter haben sicherzustellen, dass die Trainings-, Test- und Validierungsdaten, die für das zugrundeliegende KI-Modell verwendet werden, gewisse Qualitätsanforderungen erfüllen. Die Qualitätsanforderungen werden in Art. 10 KI-VO konkretisiert. Die Trainings-, Validierungs- und Testdaten müssen gemäß Art. 10 Abs. 3 KI-VO im Hinblick auf die Zweckbestimmung hinreichend repräsentativ und so weit wie möglich fehlerfrei und vollständig sein. Die Verarbeitung personenbezogener Daten ist nur dann zulässig, wenn dies zum Zweck der Überwachung und Vermeidung von Diskriminierung „unbedingt erforderlich“ ist und ergänzende Voraussetzungen erfüllt sind (Art. 10 Abs. 5 KI-VO).

- Technische Dokumentation (Art. 11 KI-VO): Anbieter müssen die Funktionsweise des KI-Systems zunächst Inverkehrbringung oder Inbetriebnahme dokumentieren und dann während des laufenden Betriebs auf dem aktuellen Stand halten. Aus der Dokumentation soll hervorgehen, wie die Vorgaben der KI-VO eingehalten werden. Dafür sollte die Dokumentation zumindest die in Anhang IV genannten Angaben enthalten (Art. 11 Abs. 1 Satz 2 KI-VO). Diese Dokumentation ist den nationalen Behörden und notifizierten Stellen in klarer und verständlicher Form zur Verfügung zu stellen.

- Aufzeichnungspflichten (Art. 12 KI-VO): Die Technik der Hochrisiko-KI-Systeme muss die automatische Aufzeichnung von Ereignissen („Protokollierung“) während des Lebenszyklus des Systems ermöglichen. Dies dient der Rückverfolgung, dass das Hochrisiko-KI-System in seinem der Zweckbestimmung angemessenen Maße funktioniert. Alle Situationen, die ein Risiko für die Gesundheit, die Sicherheit oder die Grundrechte von Personen bergen sowie alle Geschehnisse, die zu einer wesentlichen Änderung des KI-Systems führen, müssen protokolliert werden (vgl. Wendt in Wendt/Wendt, Das neue KI-Recht, § 5 Rn. 29).

- Transparenz- und Informationsanforderungen (Art. 13 KI-VO): Anbieter müssen Hochrisiko-KI-Systeme so transparent entwickeln, dass Betreiber die Ergebnisse des KI-Systems angemessen interpretieren und verwenden können. Dazu sollen Anbieter spezifische, vor allem technische Informationen in Form einer Betriebsanleitung regelmäßig digital und barrierefrei zur Verfügung stellen. Art. 13 Abs. 3 KI-VO legt fest, was die Betriebsanleitungen mindestens zu enthalten haben.

- Menschliche Aufsicht (Art. 14 KI-VO): Hochrisiko-KI-Systeme müssen so konzipiert sein, dass eine menschliche Aufsicht möglich ist. Diese ist ggf. vom Betreiber des KI-Systems auszuführen.

- Vorgaben zu Genauigkeit, Robustheit und Cybersecurity (Art. 15 KI-VO): Hochrisiko-Systeme sind so zu entwickeln, dass sie ein angemessenes Maß an Genauigkeit, Robustheit und Cybersicherheit erreichen und dieses während ihres gesamten Lebenszyklus beständig halten.

11. Welche Pflichten gelten für Anbieter, Betreiber und andere Beteiligte von KI-Systemen?

Die KI-VO berücksichtigt, dass an der Entwicklung und dem Betrieb von KI-Systemen in der Regel nicht nur ein Akteur beteiligt ist. Daher differenziert sie klar zwischen verschiedenen Akteuren und weist ihnen unterschiedliche Pflichten zu. Insbesondere obliegen dem Anbieter in diesem Zusammenhang umfassende Pflichten, die sich aus Art. 16 KI-VO ergeben. (vgl. Wendt in Wendt/Wendt, Das neue KI-Recht, § 6 Rn. 72).

a. Pflichten der Anbieter von Hochrisiko-KI-Systemen

Im Folgenden geben wir einen Überblick über die Pflichten, die Anbieter von Hochrisiko-KI-Systemen treffen:

- Anbieter müssen, um eine Zuordnung zu erleichtern, den eingetragenen Handelsnahmen bzw. die eingetragene Handelsmarke und ihre Kontaktanschrift angeben (Art. 16 lit. b KI-VO).

- Qualitätsmanagementsystem (Art. 17 KI-VO): Anbieter haben ein Qualitätsmanagementsystem einzurichten, dass die Einhaltung der KI-VO gewährleistet. Dieses System wird systematisch und ordnungsgemäß in Form schriftlicher Regeln, Verfahren und Anweisungen dokumentiert. Eine Auflistung der erforderlichen Inhalte des Qualitätsmanagementsystems findet sich in Art. 17 Abs. 1 lit. a – m KI-VO.

- Dokumentations- und Aufbewahrungspflichten (Art. 18 KI-VO und Art. 19 KI-VO): Anbieter sollen die sich aus Art. 18 Abs. 1 KI-VO ergebenden Unterlagen für einen Zeitraum von zehn Jahren ab Inverkehrbringung bzw. Inbetriebnahme aufbewahren und für die zuständigen Behörden bereithalten. Auch die von Hochrisiko-KI-Systemen erzeugten automatischen Protokolle (Art. 12 Abs. 1 KI-VO) sind aufzubewahren, sofern die Protokolle der Kontrolle der Anbieter unterliegen, Art. 19 Abs. 1 KI-VO (vgl. Wendt in Wendt/Wendt, Das neue KI-Recht, § 6 Rn. 18).

- Korrekturmaßnahmen und Informationspflicht (Art. 20 Abs. 1 KI-VO): Ist der Anbieter eines Hochrisiko-KI-Systems der Auffassung oder hat er Grund zur Annahme, dass ein von ihm in Verkehr gebrachtes oder in Betrieb genommenes Hochrisiko-KI-System nicht der KI-VO entspricht, hat er unverzüglich die erforderlichen Korrekturmaßnahmen zu ergreifen, um die Konformität des Systems herzustellen oder gegebenenfalls zurückzunehmen, zu deaktivieren oder zurückzurufen. Der Anbieter hat die Händler und ggf. die Betreiber, Bevollmächtigten und Einführer unverzüglich über die Nichtkonformität zu informieren.

- Meldepflicht (Art. 20 Abs. 2 KI-VO): Bei einem schwerwiegenden Vorfall hat der Anbieter die Marktaufsichtsbehörde zu informieren. Ein solcher liegt vor, wenn ein KI-System zu Ereignissen führt, die direkt oder indirekt den Tod oder die schwere gesundheitliche Schädigung einer Person verursachen (Art. 3 Nr. 49 lit. a KI-VO), den Betrieb einer kritischer Infrastrukturen stören (Art. 3 Nr. 49 lit. b KI-VO), Pflichten aus den Unionsrechtvorschriften zum Schutz der Grundrechte verletzen (Art. 3 Nr. 49 lit. c KI-VO) oder schwere Sach- oder Umweltschäden herbeiführen (Art. 3 Nr. 49 lit. c KI-VO).

- Zusammenarbeit mit zuständigen Behörden (Art. 21 KI-VO): Anbieter von Hochrisiko-KI-Systemen haben auf begründete Anfrage der zuständigen Behörden sämtliche Informationen und Dokumentationen zu übermitteln.

- Benennung eines Bevollmächtigten (Art. 22 KI-VO): Anbieter aus Drittländern müssen vor der Bereitstellung eines Hochrisiko-KI-Systems auf dem Unionsmarkt schriftlich einen in der Union niedergelassenen Bevollmächtigten benennen.

- Konformitätsbewertungsverfahren, Konformitätserklärung, CE-Kennzeichnung (Art. 43 KI-VO, Art. 47 KI-VO, Art. 48 KI-VO): Das Konformitätsbewertungsverfahren bildet eine zentrale Pflicht für Anbieter und muss vor Inbetriebnahme des KI-Systems durchgeführt werden. Ziel des Verfahrens ist die Überprüfung, ob das KI-System den Vorgaben der KI-VO entspricht. Unter bestimmten Voraussetzungen, wie sie in Anhang VI der KI-VO beschrieben sind, kann dieses Verfahren auch intern durchgeführt werden, wenn entsprechende Expertisen im Unternehmen vorliegen. Andernfalls übernimmt eine notifizierte Stelle gemäß Anhang VII der KI-VO die Durchführung.

Eine notifizierte Stelle ist gemäß Art. 3 Nr. 22 KI-VO eine Konformitätsbewertungsstelle im Sinne von Art. 3 Nr. 21 KI-VO, die nach den Vorgaben der KI-VO und anderen einschlägigen Harmonisierungsvorschriften der Union notifiziert wurde. Die Notifizierung erfolgt durch die sog. „notifizierende Behörde“, welche gemäß Art. 3 Nr. 19 KI-VO als nationale Behörde, für die Einrichtung und Durchführung der erforderlichen Verfahren für die Bewertung, Benennung und Notifizierung von Konformitätsbewertungsstellen und deren Überwachung zuständig ist. Die Anforderungen an notifizierte Stellen sind in Art. 31 KI-VO geregelt. Nach Art. 35 KI-VO erhalten notifizierte Stellen eine Identifizierungsnummer und werden in einem von der Kommission geführten Verzeichnis gelistet.

Im externen Bewertungsverfahren werden das Qualitätsmanagement und die technische Dokumentation überprüft. Über die Überprüfung der technischen Dokumentation lassen sich darüber hinaus Rückschlüsse über weitere Vorgaben der KI-VO wie Transparenz, Robustheit und Cybersecurity nachvollziehen. Beim internen Verfahren sind die Prüfschritte in Anhang VI der KI-VO grob skizziert. Dadurch wird dem Anbieter ein größerer Spielraum bei der Konformitätsprüfung eingeräumt. Bei wesentlichen Änderungen am KI-System ist ein erneutes Konformitätsbewertungsverfahren durchzuführen.

- Registrierungspflicht (Art. 49 Abs. 1 KI-VO): Die in Anhang III der KI-VO aufgelisteten Hochrisiko-KI-Systeme unterliegen einer Registrierungspflicht in einer EU-Datenbank gemäß Art. 71 KI-VO. Eine Ausnahme gilt für Hochrisiko-KI-Systeme, die in kritischer Infrastruktur eingesetzt werden. Die Registrierung dient der Transparenz und Nachverfolgbarkeit solcher Systeme innerhalb der Europäischen Union und unterstützt die Einhaltung der regulatorischen Vorgaben.

- Beobachtungspflicht (Art. 72 KI-VO): Anbieter sind verpflichtet ihr KI-System nach Inverkehrbringen über den gesamten Lebenszyklus des Produkts auf Grundlage eines hierfür zu erstellenden Plans zu überwachen und diese Überwachung zu dokumentieren. Diese Dokumentation und Überwachung dient der Beurteilung der Konformität des KI-Systems mit den Anforderungen aus Kapitel III Abschnitt 2 der KI-VO. (vgl. Hartmann in Martini/Wendehorst, KI-VO, Art. 72 Rn.1). Detaillierte Bestimmungen, wie ein solcher Plan auszusehen hat, sollen bis zum 02.02.2026 von der Europäischen Kommission herausgebracht werden.

b. Pflichten der Betreiber von Hochrisiko-KI-Systemen

Auch Betreiber von Hochrisiko-KI-Systemen sind Adressaten eines umfassenden Pflichtenkatalogs:

- Technische und organisatorische Maßnahmen (Art. 26 Abs. 1 KI-VO): Betreiber müssen technische und organisatorische Maßnahmen ergreifen, um sicherzustellen, dass die Vorgaben der Betriebsanleitung des Anbieters des KI-Systems erfüllt werden.

- Menschliche Aufsicht (Art. 26 Abs. 2 KI-VO): Betreiber müssen sicherstellen, dass eine menschliche Aufsicht über den Betrieb des KI-Systems durch Personal erfolgt, das die erforderliche Kompetenz, Ausbildung und Befugnis besitzt.

- Eingabedaten (Art. 26 Abs. 4 KI-VO): Soweit ein Betreiber Einfluss auf die Eingabedaten des KI-Systems hat, ist er verpflichtet sicherzustellen, dass die Daten dem vorgesehenen Zweck (Art. 3 Nr. 12 KI-VO) des KI-Systems entsprechen und hinreichend repräsentativ (Art. 3 Nr. 33 KI-VO) sind. Den Betreiber treffen daher spezifische Pflichten in Bezug auf die Eingabedaten.

Beispiel: Wird ein KI-System zur Diagnose von Hautkrankheiten (z.B. zur Erkennung von Melanomen) verwendet, liegt der Zweck des KI-System in der zuverlässigen Diagnose von Hautkrankheiten bei Menschen mit unterschiedlichen Altersgruppen, Geschlechtern und Hauttypen. Der Betreiber muss in diesem Fall sicherstellen, dass die Eingabedaten, soweit er Einfluss auf diese hat, stets dem vorgesehenen Zweck entsprechen und ausreichend repräsentativ sind. Er muss sich also fragen, ob das System über ausreichend Daten (Hauttypen, Krankheitsbilder usw.) verfügt, um eine zuverlässige Diagnose treffen zu können. Dies dient insbesondere einer zuverlässigen und diskriminierungsfreien Arbeit des KI-Systems.

Dieser Ansatz ist nicht ohne Kritik geblieben, da fraglich ist, wie weit eine solche Verpflichtung des Betreibers gehen kann. Eigentlich sollte es Aufgabe der Anbieter sein, ihre KI-Systeme so zu gestalten, dass Diskriminierung gar nicht erst auftritt (vgl. I. Eisenberger in Martini/Wendehorst, KI-VO, Art. 26 Rn. 564). Im obigen Beispiel müsste bereits der Anbieter sicherstellen, dass sein KI-System nicht ausschließlich Daten von jungen Menschen mit einem hellen Hauttyp als Grundlage der Analysen verwendet, sondern eine repräsentative Datengrundlage schafft.

- Überwachungs- und Meldepflichten (Art. 26 Abs. 5 KI-VO): Fürchtet der Betreiber, dass die Verwendung des KI-Systems entsprechend den Vorgaben der Betriebsanleitung ein Risiko für die Gesundheit, Sicherheit oder die Grundrechte von Personen birgt, hat er unverzüglich den Anbieter, Händler und die zuständige Marktüberwachungsbehörde in Kenntnis zu setzen und die Verwendung des KI-Systems auszusetzen.

- Aufbewahrungspflichten (Art. 26 Abs. 6 KI-VO): Betreiber müssen die automatisch vom KI-System erzeugten Protokolle für mindestens sechs Monate aufbewahren. Stehen der Aufbewahrung Rechtsvorschriften zum Schutz personenbezogener Daten entgegen, gehen diese vor.

- KI-Systeme am Arbeitsplatz (Art. 26 Abs. 7 KI-VO): Soll das KI-System am Arbeitsplatz verwendet werden, hat der Betreiber die Arbeitnehmervertreter und die betroffenen Arbeitnehmer darüber zu informieren.

- Unterrichtung von Betroffenen (Art. 26 Abs. 11 KI-VO): Die Betroffenen sind vom Betreiber darüber zu informieren, wenn das KI-System Entscheidungen ihnen gegenüber trifft oder bei einer solchen Entscheidung mitwirkt. Sie sollen in die Lage versetzt werden, zu erkennen, dass sie Gegenstand KI-gestützter Entscheidungsfindung sind.

- Zusammenarbeit mit Behörden (Art. 26 Abs. 12 KI-VO): Die Betreiber haben sicherzustellen, dass sie mit den zuständigen Behörden zusammenarbeiten, um die Anforderungen der KI-VO an das KI-System zu erfüllen.

- Grundrechte-Folgenabschätzung (Art. 27 KI-VO): Eine Grundrechte-Folgenabschätzung ist nur von Einrichtungen des öffentlichen Rechts, von privaten Einrichtungen, die öffentliche Dienste erfüllen und von Banken und Versicherungen vorzunehmen, wenn Hochrisiko-KI-Systeme zur Kreditwürdigkeitsprüfung (Anhang III Nr. 5 lit. b der KI-VO) oder für die Risikobewertung und Preisbildung von Lebens- und Krankenversicherungen (Anhang III Nr. 5 lit. c der KI-VO) für natürliche Personen eingesetzt werden. Im Rahmen der Grundrechte-Folgenabschätzung sind die möglichen Auswirkungen des KI-Systems auf die Grundrechte von Bürgern abzuschätzen. Die Grundrecht-Folgenabschätzung beschränkt sich allein auf Hochrisiko-KI-Systeme nach Art. 6 Abs. 2 KI-VO in Verbindung mit Anhang III der KI-VO:

- Biometrik (Ziff.1),

- Allgemeine und berufliche Bildung (Ziff. 3),

- Beschäftigung, Personalmanagement und Zugang zur Selbstständigkeit (Ziff. 4),

- Zugang zu grundlegenden privaten und öffentlichen Leistungen (Ziff. 5),

- Strafverfolgung (Ziff. 6),

- Migration, Asyl und Grenzkontrolle (Ziff. 7) sowie

- Rechtspflege und demokratische Prozesse (Ziff. 8).

Art. 27 Abs. 1 KI-VO zählt die erforderlichen Informationen auf, die die Grundrechte-Folgenabschätzung erhalten muss. Die Grundrechts-Folgenabschätzung ist vor der Inbetriebnahme durchzuführen.

c. Pflichten der Händler von Hochrisiko-KI-Systemen

Nach Art. 24 KI-VO sind Händler u.a. verpflichtet zu überprüfen,

- ob das Hochrisiko-KI-System mit der erforderlichen CE-Kennzeichnung versehen ist,

- eine Kopie der Konformitätserklärung sowie der Betriebsanleitung beigefügt ist und

- ob der Anbieter bzw. ggf. der Einführer des Systems seine Pflichten (Art. 16 lit. b und c KI-VO sowie Art. 23 Abs. 3 KI-VO) erfüllt hat.

Erst nach positiver Kontrolle darf das KI-System auf den Markt gebracht werden.

d. Allgemeine Pflichten für Anbieter und Betreiber aller Risikostufen

Für Anbieter und Betreiber von KI-Systemen aller Risikostufen gelten die folgenden Pflichten:

- KI-Kompetenz (Art. 4 KI-VO): Anbieter und Betreiber haben sicherzustellen, dass ihr Personal und andere Personen, die in ihrem Auftrag mit dem Betrieb des KI-Systems befasst sind, über ein ausreichendes Maß an KI-Kompetenz verfügen. Die erforderlichen Kenntnisse unterscheiden sich je nach Einsatzbereich der KI. Menschen, die mit KI-Systemen arbeiten, müssen ein Bewusstsein dafür haben, wie sich von der KI getroffene Entscheidungen auswirken können. Sie sollen in der Lage sein, den Output des KI-Systems zu interpretieren. Die vermittelten Kenntnisse sollen der Einhaltung der KI-VO dienen.

- Freiwillige Verhaltenskodizes (Art. 95 Abs. 3 KI-VO): Anbieter und Betreiber von KI-Systemen können freiwillig Verhaltenskodizes aufstellen. Dabei können zusätzliche Anforderungen z.B. in Bezug auf ökologische Nachhaltigkeit Gegenstand der Verhaltenskodizes sein.

e. Pflichten der Anbieter von KI-Modellen mit allgemeinem Verwendungszweck

Für KI-Modelle mit allgemeinem Verwendungszweck gelten gesonderte Regelungen, die auf ihre spezifischen Risiken zugeschnitten sind.

- Laufende technische Dokumentation des Modells (Art. 53 Abs. 1 Satz 1 lit. a KI-VO): Die erforderlichen Informationen, welche zu dokumentieren sind, sind in Anhang XI Abschnitt 1 der KI-VO aufgelistet. Die Dokumentation muss dem Büro für Künstliche Intelligenz und den zuständigen nationalen Behörden auf Anfrage ausgehändigt werden. Unter „Büro für Künstliche Intelligenz“ ist laut Art. 3 Nr. 47 KI-VO die Aufgabe der Kommission zu verstehen.

- Informationspflicht (Art. 53 Abs. 1 Satz 1 lit. b KI-VO): Anbieter von KI-Modellen mit allgemeinem Verwendungszweck haben Informationen und Dokumentationen bereitzustellen, um anderen Anbietern die Integration dieser Modelle in ihre eigenen KI-Systeme zu ermöglichen. Diese Informationen müssen dazu geeignet sein, erkennen zu können, wozu das KI-Modell im Stande ist und wie die Anforderungen der KI-VO eingehalten werden können. Die erforderlichen Informationen sind in Anhang XII der KI-VO aufgelistet.

Die Pflichten nach Art. 53 Abs. 1 lit. a und b KI-VO gelten nicht für quelloffene KI-Modelle, bei denen die Modifikation und Weitergabe des Modells erlaubt ist und Parameter, Architektur sowie Nutzungsinformationen öffentlich zugänglich sind. Eine Rückausnahme gilt für Modelle mit systemischem Risiko (Art. 53 Abs. 2 KI-VO) - Urheberrecht (Art. 53 Abs. 1 Satz 1 lit. c KI-VO): Anbieter müssen eine Strategie zur Einhaltung des Urheberrechts erarbeiten. Dies zielt auf das Training von KI-Modellen und soll insbesondere zur Ermittlung und Einhaltung des Rechtevorbehalts im Rahmen des Text- und Data-Minings dienen, und zwar unter Einsatz modernster Technologien (Art. 4 Abs. 3 DSM-RL bzw. § 44b Abs. 3 UrhG). Die Pflichten aus Art. 53 KI-VO gelten auch für Anbieter, die ihre Modelle unter einer freien und quelloffenen Lizenz bereitstellen, da die Open-Source-Ausnahme des Art. 53 Abs. 2 KI-VO die urheberrechtlichen Regelungen nicht erfasst (Erwgr. 104 KI-VO). Für kleine oder mittlere Unternehmen (KMU) gelten keine Ausnahmen, es soll nur vereinfachte Verfahren geben (Erwgr. 104 Satz 2 KI-VO).

- Zusammenfassung der für das KI-Training genutzten Inhalte (Art. 53 Abs. 1 Satz 1 lit. d KI-VO): KI-Anbieter müssen darüber hinaus eine hinreichend detaillierte Zusammenfassung der verwendeten Trainingsdaten veröffentlichen.

- Zusammenarbeit mit Behörden (Art. 53 Abs. 3 KI-VO)

- Benennung eines Bevollmächtigten (Art. 54 KI-VO): Wenn der Anbieter außerhalb der EU niedergelassen ist.

Für die Pflichten der Anbieter von KI-Modellen mit allgemeinem Verwendungszweck sollen harmonisierten Normen ausgearbeitet werden. Hält man diese ein, wird nach Art. 53 Abs. 4 Satz 2 KI-VO vermutet, dass das KI-Modell mit den jeweiligen Anforderungen der KI-VO konform ist. Bis die harmonisierten Normen fertiggestellt sind, können die Anbieter auf Praxisleitfäden zurückgreifen, die gemäß Art. 56 KI-VO von der EU erstellt werden (Art. 53 Abs. 4 KI-VO) und bis spätestens 02.05.2025 vorliegen sollen (Art. 56 Abs. IX KI-VO). Außerdem hat die Europäische Kommission die Befugnis, Mess- und Berechnungsmethoden im Einzelnen zu entwickeln, um eine einheitliche Dokumentation von KI-Modellen mit allgemeinem Verwendungszweck zu ermöglichen (Art. 53 Abs. 5 KI-VO).

f. Pflichten der Anbieter von KI-Modellen mit allgemeinem Verwendungszweck und systemischem Risiko

Für Anbieter von KI-Modellen mit allgemeinem Verwendungszweck und systemischem Risiko gelten zusätzliche Pflichten:

- Mitteilungsobliegenheit (Art. 52 Abs. 1 KI-VO): Anbieter sollen der Europäischen Kommission mitteilen, dass ihr KI-Modell ein KI-Modell mit allgemeinem Verwendungszweck und systemischem Risiko ist.

- Modellbewertung zum Erfassen und Mindern von Risiken (Art. 55 Abs. 1 lit. a, b KI-VO): Anbieter haben eine Modellbewertung mit standardisierten Protokollen und Instrumenten zu erstellen, die die systemischen Risiken erfasst und mindert. Ebenso haben die Anbieter sich aus dem KI-Modell ergebende systemische Risiken auf Unionsebene zu bewerten und zu mindern.

- Informieren über schwerwiegende Vorfälle (Art. 55 Abs. 1 lit. c KI-VO): Anbieter müssen Informationen über schwerwiegende Vorfälle sowie potenzielle Abhilfemaßnahmen erfassen und dokumentieren. Die zuständigen Behörden sind darüber zu informieren.

- Cybersecurity (Art. 55 Abs. 1 lit. d KI-VO): Anbieter müssen ein angemessenes Maß an Cybersecurity sicherstellen.

- Anbieter von KI-Modellen mit allgemeinem Verwendungszweck mit systemischem Risiko müssen zusätzliche Informationen im Rahmen der technischen Dokumentation nach Art. 53 Abs. 1 Satz 1 lit. a KI-VO bereitstellen. Diese befinden sich in Anhang XI Abschnitt 2 der KI-VO.

Auch für KI-Modelle mit allgemeinem Verwendungszweck mit systemischem Risiko soll eine harmonisierte Norm ausgearbeitet werden. Bis dahin können sich die Anbieter auf die Praxisleitfäden des Art. 56 KI-VO stützen (Art. 55 Abs. 2 KI-VO).

g. Konkretisierung durch die EU

Die KI-VO ist nur ein Teil des neuen Systems zur Regulierung von KI. Art. 40 Abs. 1 KI-VO sieht die Erstellung sog. harmonisierter Normen vor, die vom Komitee JTC 21, einem Zusammenschluss der europäischen Normungsorganisationen CEN (Europäisches Komitee für Normung) und CENELEC (Europäisches Komitee für elektronische Normung), erarbeitet werden. Aus Art. 40 Abs. 2 KI-VO ergeben sich Einzelheiten zum Anwendungsbereich, zu den Fristen und zu den rechtlichen Anforderungen, die die Normen erfüllen müssen. (vgl. Wendt in Wendt/Wendt, Das neue KI-Recht, § 6 Rn. 1-3). Zudem wird die Europäische Kommission gemäß Art. 96 KI-VO Leitlinien zur praktischen Anwendung der KI-VO erstellen.

Die harmonisierten Normen werden bis Ende 2025 erwartet. Bis dahin herrscht große Unsicherheit darüber, wie die Vorgaben der Verordnung umzusetzen sind (vgl. Kilian/Denga: Das Testen und Zertifizieren von KI-Systemen, NJW 2024, 2945).

12. Welche Sanktionen drohen bei Verstoß gegen die KI-Verordnung?

Die KI-VO sieht bei Verstößen ein gestaffeltes Sanktionssystem vor. Die Höhe der Geldbuße ist abhängig von Art, Schwere und den Folgen des Verstoßes sowie u.a. auch von dem Jahresumsatz, der Marktmacht und der Größe des Unternehmens. Es bedarf gemäß Art. 99 Abs. 7 KI-VO einer umfassenden Beurteilung der Umstände des Einzelfalls.

Bei Missachtung des Verbots der in Art. 5 KI-VO genannten Praktiken werden Geldbußen von bis zu 35 Mio. Euro oder – im Falle von Unternehmen – bis zu 7 % des gesamten weltweiten Jahresumsatzes des vorangegangenen Geschäftsjahres verhängt, je nachdem, welcher Betrag höher ist (Art. 99 Abs. 3 KI-VO).

Bei Verstößen gegen die

- Pflichten der Anbieter (Art. 16 KI-VO);

- Pflichten der Bevollmächtigten (Art. 22 KI-VO);

- Pflichten der Einführer (Art. 23 KI-VO);

- Pflichten der Händler (Art. 24 KI-VO);

- Pflichten der Betreiber (Art. 26 KI-VO);

- für notifizierte Stellen geltenden Anforderungen und Pflichten (Art. 31 KI-VO, Art. 33 Abs. 1, 3 und 4 KI-VO bzw. Art. 34 KI-VO);

- Transparenzpflichten für Anbieter und Betreiber (Art. 50 KI-VO),

werden Geldbußen von bis zu 15 Mio. Euro oder – im Falle von Unternehmen – bis zu 3 % des gesamten weltweiten Jahresumsatzes des vorangegangenen Geschäftsjahres verhängt, je nachdem, welcher Betrag höher ist (Art. 99 Abs. 4 KI-VO).

Bei Mängeln in der Dokumentation oder Auskunftserteilung werden Geldbußen von bis zu 7,5 Mio. Euro oder – im Falle von Unternehmen – von bis zu 1 % des gesamten weltweiten Jahresumsatzes des vorangegangenen Geschäftsjahres verhängt (Art. 99 Abs. 5 KI-VO).

Für Anbieter von KI-Modellen mit allgemeinem Verwendungszweck gelten die gesonderten Sanktionsvorschriften aus Art. 101 KI-VO.

13. Was ist hinsichtlich des Datenschutzrechts zu beachten?

Die DSGVO findet neben der KI-VO Anwendung. Da Anbieter und Betreiber im Umgang mit personenbezogenen Daten häufig Verantwortliche im Sinne des Datenschutzrechts sind, müssen diese die Vorgaben der DSGVO beachten. Das gilt beispielsweise für personenbezogene Eingabedaten durch Kunden, die mit einem KI-gestützten Chatbot interagieren. Muss eine Datenschutz-Folgenabschätzung gemäß der DSGVO gemacht werden, ist zu beachten, dass die nach Art. 13 KI-VO bereitgestellten Daten hierfür verwendet werden müssen.

Hinweis: An diesem Beitrag haben Rechtsanwältin Katja Schott sowie unsere wissenschaftliche Mitarbeiterin Laura Hellfeuer mitgewirkt.